模型:

google/flan-t5-large

英文

英文FLAN-T5大型模型的模型卡

目录

简介

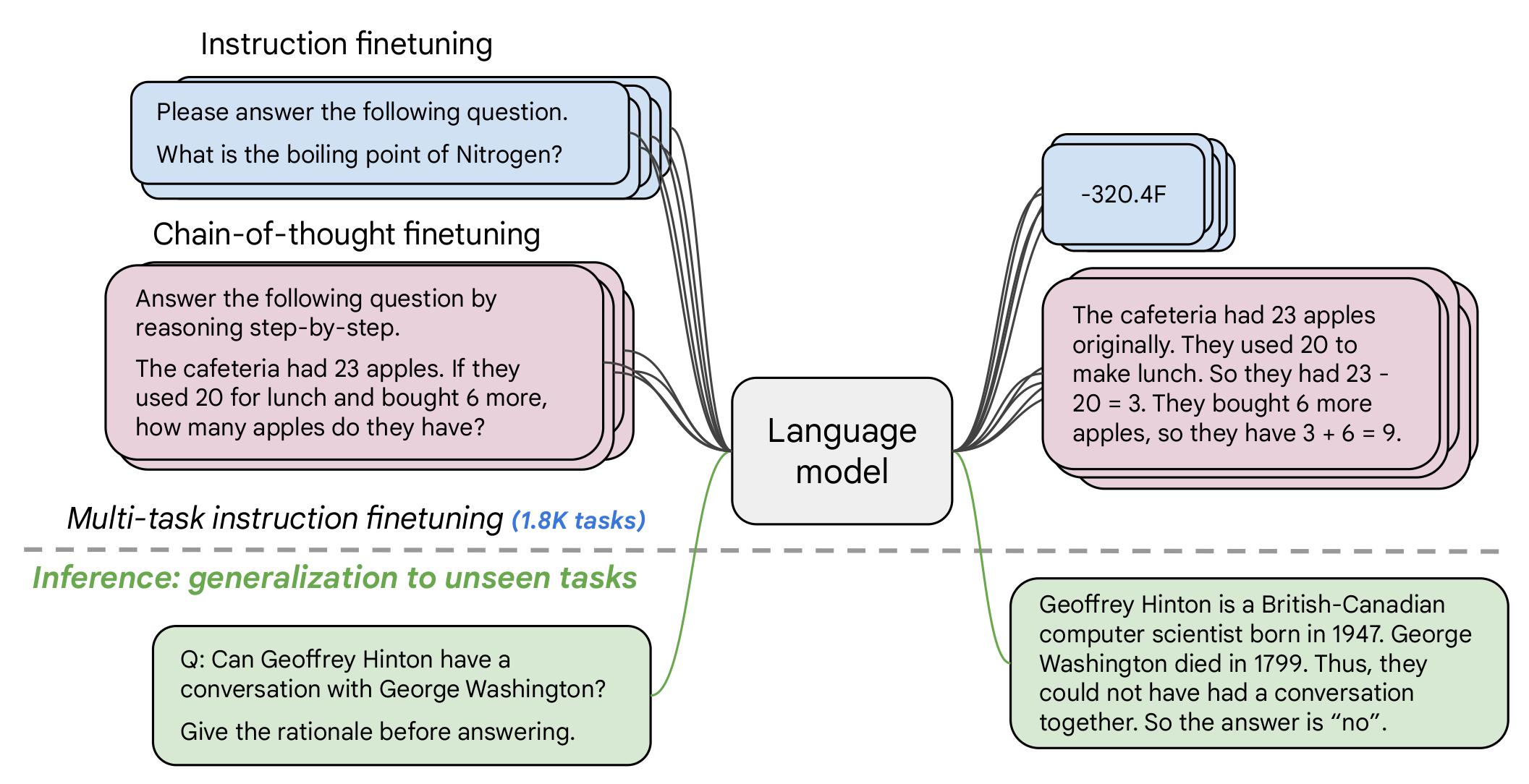

如果您已经了解T5,那么FLAN-T5在各个方面都更加优秀。相同数量的参数下,这些模型在多达1000个额外任务上进行了微调,涵盖了更多语言。正如摘要的前几行中提到的:

Flan-PaLM 540B在诸多基准测试中均取得了最新的成绩,比如在五shot MMLU任务上达到了75.2%的准确率。我们还公开发布了Flan-T5的检查点,1,其在少样本情况下的性能与更大模型(如PaLM 62B)相比同样出色。总体而言,指令微调是一种提高预训练语言模型性能和可用性的通用方法。

免责声明:本模型卡的内容是由Hugging Face团队编写的,并且其中的部分内容来自于 T5 model card 。

模型详情

模型描述

- 模型类型:语言模型

- 自然语言处理语种:英语、西班牙语、日语、波斯语、印地语、法语、汉语、孟加拉语、古吉拉特语、德语、泰卢固语、意大利语、阿拉伯语、波兰语、泰米尔语、马拉地语、马拉雅拉姆语、奥里亚语、旁遮普语、葡萄牙语、乌尔都语、加利西亚语、希伯来语、韩语、加泰罗尼亚语、泰语、荷兰语、印度尼西亚语、越南语、保加利亚语、菲律宾语、中央高棉语、老挝语、土耳其语、俄语、克罗地亚语、瑞典语、约鲁巴语、库尔德语、缅甸语、马来语、捷克语、芬兰语、索马里语、塔加洛语、斯瓦西里语、僧伽罗语、卡纳达语、壮语、伊博语、科萨语、罗马尼亚语、海地语、爱沙尼亚语、斯洛伐克语、立陶宛语、希腊语、尼泊尔语、阿萨姆语、挪威语

- 许可证:Apache 2.0

- 相关模型: All FLAN-T5 Checkpoints

- 原始检查点: All Original FLAN-T5 Checkpoints

- 了解更多信息的资源:

使用方法

以下是使用该模型的示例脚本的详细说明:

使用PyTorch模型

在CPU上运行模型

点击展开

from transformers import T5Tokenizer, T5ForConditionalGeneration

tokenizer = T5Tokenizer.from_pretrained("google/flan-t5-large")

model = T5ForConditionalGeneration.from_pretrained("google/flan-t5-large")

input_text = "translate English to German: How old are you?"

input_ids = tokenizer(input_text, return_tensors="pt").input_ids

outputs = model.generate(input_ids)

print(tokenizer.decode(outputs[0]))

在GPU上运行模型

点击展开# pip install accelerate

from transformers import T5Tokenizer, T5ForConditionalGeneration

tokenizer = T5Tokenizer.from_pretrained("google/flan-t5-large")

model = T5ForConditionalGeneration.from_pretrained("google/flan-t5-large", device_map="auto")

input_text = "translate English to German: How old are you?"

input_ids = tokenizer(input_text, return_tensors="pt").input_ids.to("cuda")

outputs = model.generate(input_ids)

print(tokenizer.decode(outputs[0]))

在GPU上使用不同精度运行模型

FP16 点击展开# pip install accelerate

import torch

from transformers import T5Tokenizer, T5ForConditionalGeneration

tokenizer = T5Tokenizer.from_pretrained("google/flan-t5-large")

model = T5ForConditionalGeneration.from_pretrained("google/flan-t5-large", device_map="auto", torch_dtype=torch.float16)

input_text = "translate English to German: How old are you?"

input_ids = tokenizer(input_text, return_tensors="pt").input_ids.to("cuda")

outputs = model.generate(input_ids)

print(tokenizer.decode(outputs[0]))

INT8 点击展开# pip install bitsandbytes accelerate

from transformers import T5Tokenizer, T5ForConditionalGeneration

tokenizer = T5Tokenizer.from_pretrained("google/flan-t5-large")

model = T5ForConditionalGeneration.from_pretrained("google/flan-t5-large", device_map="auto", load_in_8bit=True)

input_text = "translate English to German: How old are you?"

input_ids = tokenizer(input_text, return_tensors="pt").input_ids.to("cuda")

outputs = model.generate(input_ids)

print(tokenizer.decode(outputs[0]))

应用

直接应用和下游应用

作者在 the original paper's model card 中写道:

主要用途是用于语言模型的研究,包括零样本自然语言处理任务和上下文少样本学习自然语言处理任务,例如推理和问答;推动公平性和安全性研究,并了解当前大型语言模型的局限性

详情请参阅 research paper 。

超出范围的用途

需要更多信息。

偏见、风险和限制

以下信息是从模型的 official model card 中复制的:

语言模型,包括Flan-T5,有潜在的以有害方式生成语言的可能性,参考Rae等人(2021)。在没有事先评估特定应用程序的安全性和公平性问题的情况下,不应直接使用Flan-T5在任何应用程序中。

道德考虑和风险

Flan-T5在未经筛选的明确内容和现有偏见评估的大量文本数据上进行了微调。因此,模型本身可能容易生成不当内容或复制基础数据中固有的偏见。

已知限制

Flan-T5尚未在实际应用程序中进行测试。

敏感用途:

Flan-T5不应用于任何不可接受的用例,例如生成滥用性言论。

训练细节

训练数据

该模型使用了多种任务进行训练,包括原始论文图2中描述的任务(以下是表格中的任务):

训练过程

根据 original paper 中的模型卡说明:

这些模型是基于预训练的T5(Raffel et al., 2020)并通过指令进行微调以获得更好的零样本和少样本性能。每种T5模型尺寸都有一个经过微调的Flan模型。

使用TPU v3或TPU v4 pods进行训练,使用 t5x 代码库和 jax 。

评估

测试数据、因素和指标

作者对模型进行了各种任务的评估,涵盖了多种语言(总共1836个)。以下是一些定量评估的表格,请参阅完整详情请检查 research paper 。

结果

有关FLAN-T5-Large的完整结果,请参阅 research paper ,表格3。

环境影响

可以使用 Machine Learning Impact calculator 中提供的 Lacoste et al. (2019) 估计碳排放量。

- 硬件类型:Google Cloud TPU Pods - TPU v3或TPU v4 | 芯片数 ≥ 4

- 使用时间:需要更多信息

- 云提供商:GCP

- 计算区域:需要更多信息

- 排放碳量:需要更多信息

引用

BibTeX:

@misc{https://doi.org/10.48550/arxiv.2210.11416,

doi = {10.48550/ARXIV.2210.11416},

url = {https://arxiv.org/abs/2210.11416},

author = {Chung, Hyung Won and Hou, Le and Longpre, Shayne and Zoph, Barret and Tay, Yi and Fedus, William and Li, Eric and Wang, Xuezhi and Dehghani, Mostafa and Brahma, Siddhartha and Webson, Albert and Gu, Shixiang Shane and Dai, Zhuyun and Suzgun, Mirac and Chen, Xinyun and Chowdhery, Aakanksha and Narang, Sharan and Mishra, Gaurav and Yu, Adams and Zhao, Vincent and Huang, Yanping and Dai, Andrew and Yu, Hongkun and Petrov, Slav and Chi, Ed H. and Dean, Jeff and Devlin, Jacob and Roberts, Adam and Zhou, Denny and Le, Quoc V. and Wei, Jason},

keywords = {Machine Learning (cs.LG), Computation and Language (cs.CL), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {Scaling Instruction-Finetuned Language Models},

publisher = {arXiv},

year = {2022},

copyright = {Creative Commons Attribution 4.0 International}

}