英文

英文快速入门

1.0 版本(2019年11月25日)

我们通常建议使用cased模型。

介绍芬兰BERT的论文: arXiv:1912.07076

这是什么?

这是Google的 BERT 深度迁移学习模型的一个版本,专为芬兰语而设计。该模型可以微调以实现各种芬兰自然语言处理任务的最新效果。

FinBERT采用了一个自定义的50,000个词片段词汇表,比之前从Google发布的 multilingual BERT 模型的覆盖范围更好:

| Vocabulary | Example |

|---|---|

| FinBERT | Suomessa vaihtuu kesän aikana sekä pääministeri että valtiovarain ##ministeri . |

| Multilingual BERT | Suomessa vai ##htuu kes ##än aikana sekä p ##ää ##minister ##i että valt ##io ##vara ##in ##minister ##i . |

FinBERT已经在从新闻、在线讨论和互联网爬虫中收集的30亿个标记(24B个字符)的芬兰文本上进行了100万步的预训练。相比之下,多语言BERT是在维基百科文本上进行训练的,其中芬兰维基百科的文本量约为用于训练FinBERT的文本量的3%。

这些特点使得FinBERT在微调芬兰自然语言处理任务时不仅优于多语言BERT,而且优于先前提出的所有模型。

结果

文档分类

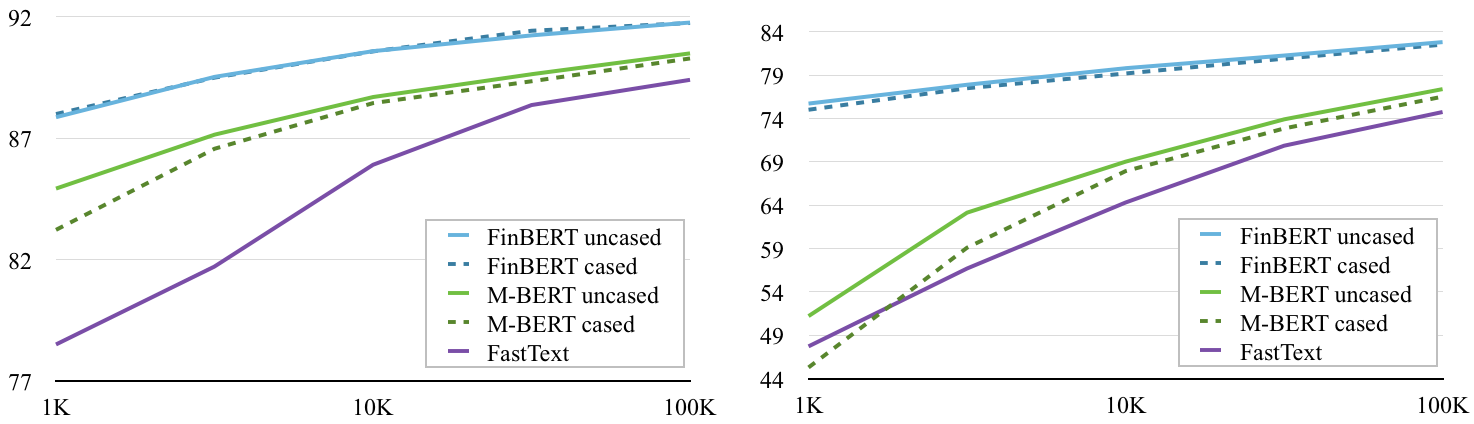

在Yle新闻(左)和Ylilauta在线讨论(右)语料库上,FinBERT在文档分类上的性能超过了多语言BERT(M-BERT)在一系列训练集大小上的性能。(包含参考的基准分类性能,其中包括 FastText )

[ code ] [ Yle data ] [ Ylilauta data ]

命名实体识别

评估结果使用FiNER语料库( Ruokolainen et al 2019 )

| Model | Accuracy |

|---|---|

| FinBERT | 92.40% |

| Multilingual BERT | 90.29% |

| 1239321 (rule-based) | 86.82% |

(来自 Ruokolainen et al. 2019 的FiNER标记结果)

词性标注

在三个使用 Universal Dependencies 词性标签进行注释的芬兰文语料库上进行评估:Turku Dependency Treebank(TDT),FinnTreeBank(FTB)和Parallel UD treebank(PUD)

| Model | TDT | FTB | PUD |

|---|---|---|---|

| FinBERT | 98.23% | 98.39% | 98.08% |

| Multilingual BERT | 96.97% | 95.87% | 97.58% |

先前版本

0.2 版本

2019年10月24日。BERT基本的非大小写模型的测试版本,从头开始训练,使用芬兰新闻、在线讨论和爬取的数据语料库。

在这里下载模型: bert-base-finnish-uncased.zip

0.1 版本

2019年9月30日。我们发布了一个基本的带大小写模型的测试版本,从头开始使用芬兰新闻、在线讨论和爬取的数据语料库进行训练。

在这里下载模型: bert-base-finnish-cased.zip